Într-un peisaj al Internetului lucrurilor (IoT) și al Inteligenței Artificiale (AI) în continuă expansiune, cantitatea de date care trebuie procesată și stocată crește rapid. Pentru multe aplicații, edge AI poate reduce povara asupra centrelor de date de calcul în cloud utilizând procesoare foarte optimizate, aducând în același timp beneficii importante, cum ar fi latența, confidențialitatea și securitatea îmbunătățite, consumul redus de energie și eficiența sporită a lățimii de bandă.

Cu toate acestea, spațiul IoT edge AI este caracterizat de un ecosistem fragmentat cu procesoare, software, instrumente și compilatoare diverse. Această fragmentare este în contrast puternic cu ecosistemul relativ matur al AI bazat pe cloud și este frustrantă pentru dezvoltatori. Este necesară o abordare mai coerentă dacă se dorește ca potențialul edge AI să revoluționeze experiența utilizatorului final.

Peisajul actual al AI și IoT

Având o infrastructură robustă și, relativ, bine stabilită, cloud-ul a fost tradiționalul motor al AI, valorificând GPU-urile și capabilitățile de hiperscalare pentru a gestiona cea mai mare parte a procesării AI. Maturitatea limbajului și a metodologiilor utilizate în AI bazat pe cloud semnalează un ecosistem evoluat și stabil. Cu toate acestea, pe măsură ce ne îndepărtăm de cloud și ne apropiem de dispozitivele periferice, peisajul devine din ce în ce mai eterogen. Absența standardelor adoptate pe scară largă în spațiul IoT duce la o experiență complexă și dezarticulată atât pentru utilizatori, cât și pentru dezvoltatori.

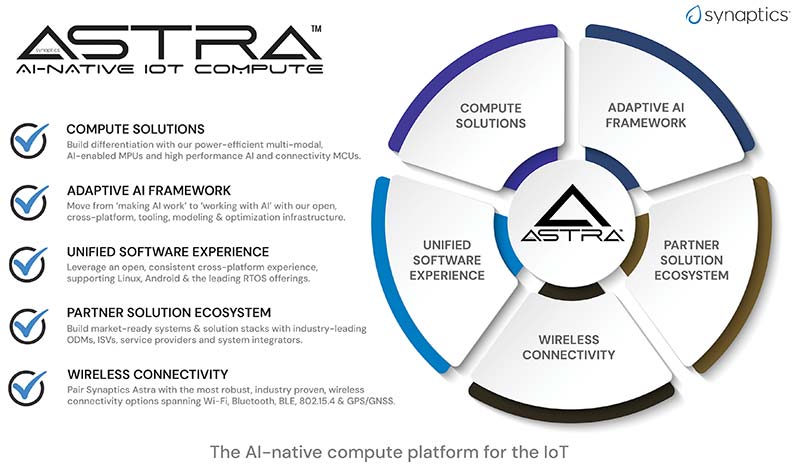

Platforma de calcul embedded “AI-Native” Astra de la Synaptics unifică ecosistemul IoT fragmentat, oferind o experiență standardizată dezvoltatorilor pe toate segmentele de piață. (Sursă imagine: Synaptics)

Spre deosebire de cloud, care este propice rulării modelelor de limbaj de mari dimensiuni (LLM) și, totodată, mari consumatoare de energie, dispozitivele IoT necesită modele optimizate pentru medii cu resurse mai limitate în termeni de putere și memorie. În plus, pentru antrenarea modelelor în cloud, puteți utiliza unele soluții precum TensorFlow și poate încă alte două framework-uri de modele proprietare, dar atunci când treceți la dispozitivele IoT de nivel mai larg, destinate consumatorilor, întreprinderilor și industriei, ar putea exista multe platforme și protocoale diferite. Încercarea de a le face pe toate să funcționeze împreună poate fi o provocare.

Disputa hardware vs. software

Nepotrivirea dintre calendarul de dezvoltare software și cel al hardware-ului sporește și mai mult complexitatea. Aplicațiile software integrează rapid capabilități AI încorporate, cum ar fi algoritmii de învățare profundă, care nu sunt întotdeauna compatibile cu hardware-ul pe care rulează.

Ce opțiuni aveți, în prezent, dacă doriți să integrați AI în cadrul unui proiect IoT? Producătorii de dispozitive IoT încearcă, adesea, să adapteze pentru aplicațiile lor siliciul dezvoltat pentru principalele piețe, precum cea a telefoanelor inteligente sau a infrastructurii celulare. Siliciul disponibil care încorporează motoare de inferență AI vă va oferi o capacitate de accelerare de 1 TOPS sau 2 TOPS. După aceasta, apare un decalaj semnificativ pe piață, ajungându-se la 16 TOPS, 32 TOPS, 48 TOPS și mai mult. Deși această abordare a reutilizării siliciului poate fi funcțională, ea duce la ineficiențe în ceea ce privește puterea de calcul și consumul de energie, care nu pot fi permise dispozitivelor IoT.

Studiile estimează că piața siliciului de calcul edge AI IoT crește cu aproximativ 15% de la an la an și va atinge o valoare cuprinsă între 20 și 25 de miliarde USD în următorii trei-patru ani. Aceasta este o piață foarte sănătoasă, dar dacă soluțiile de siliciu de calcul AI disponibile nu corespund nevoilor producătorilor de dispozitive IoT, va exista un mare gol de umplut.

Eficiența energetică, latența, confidențialitatea, ușurința procesului de dezvoltare și performanța sunt principalele provocări în integrarea AI la periferia IoT. Modelele de limbaj de mari dimensiuni (LLM) bazate pe cloud consumă multă energie, în timp ce se așteaptă ca dispozitivele IoT să opereze la niveluri de energie mult mai scăzute, oferind în același timp performanță. Această discrepanță în profilurile energetice necesită un echilibru atent între hardware și software pentru a garanta că dispozitivele IoT pot rula eficient aplicații AI, cu un consum minim de energie.

Vestea bună este că, în contextul actual, inginerii care doresc să integreze AI în proiectele IoT au la dispoziție o gamă largă de opțiuni. Provocarea constă în alegerea platformei potrivite. Multe dintre plăcile de referință și platformele existente nu sunt special proiectate pentru aplicațiile IoT, ceea ce duce la dificultăți de integrare și performanțe sub nivelul optim. Este evidentă nevoia unei soluții ușor disponibile care să răspundă cerințelor speciale de performanță și de consum energetic ale aplicațiilor IoT. Pe măsură ce AI devine din ce în ce mai răspândită, inferența securizată și respectarea confidențialității utilizatorilor devin din ce în ce mai importante.

Personalizare bazată pe modele multiple

Multe aplicații AI IoT sunt bazate pe viziune, iar viziunea, ca modalitate de detectare, poate fi utilizată pentru a permite detectarea prezenței, detectarea atenției, estimarea poziției corpului și recunoașterea gesturilor – toate acestea sunt cazuri de utilizare consacrate, ușor disponibile, utilizând cloud-ul. Următorul pas constă în implementarea acestor funcții la nivel local într-un sistem IoT prin utilizarea unor modele optimizate, care răspund unor constrângeri mai stricte legate de resurse în ceea ce privește puterea, costul, spațiul și memoria.

În același timp, este posibil să doriți să integrați alte funcții, precum voce și audio, pentru mai mult context, astfel încât să oferiți utilizatorilor experiențe personalizate. În prezent, sunt în curs de dezvoltare numeroase alte soluții interesante pentru îmbunătățirea experienței utilizatorului. De exemplu, o abordare hibridă vă permite să actualizați modelele pe baza metadatelor trimise în cloud. Modelul este reantrenat și trimis înapoi la dispozitivul IoT, pentru a fi cât mai adaptat la cerințele consumatorului. Este vorba despre unul dintre numeroasele canale de comunicație dintre periferie și cloud.

Conexiunea de tip “loopback” (trimitere de date înapoi la punctul de origine) va fi esențială în lumea IoT, unde, în locul unui model care rulează o singură dată în hardware, acesta poate fi actualizat și mult mai personalizat, în timp. AI, fie că este vorba despre o boxă inteligentă, o cameră de securitate pentru locuință sau căști, învață automat din tiparele, comportamentele sau nevoile utilizatorului. Apoi se poate actualiza ori de câte ori se conectează la un telefon sau la o rețea Wi-Fi.

Tehnologiile IoT de reducere a consumului de energie implementate în dispozitivele destinate publicului larg pot deveni mai inteligente și autonome, putând să se extindă dincolo de sfera comercială, către sectorul întreprinderilor și cel industrial. De exemplu, în domeniul securității. Îmbunătățirile continue ale modelelor AI pe dispozitivele IoT periferice sporesc eficiența și deschid calea către sisteme mai sofisticate și autonome.

Nevoia de instrumente Open-Source pentru Edge AI

Succesul nu constă doar în optimizarea unui model; acel model trebuie apoi integrat într-un pipeline de aplicații. Să luăm, de exemplu, streamingul video. Cum integrați un model AI – de la obținerea înregistrării video, decodarea acesteia, crearea unui model AI, apoi codificarea și trimiterea acesteia?

Deși optimizarea modelelor AI în cloud devine din ce în ce mai frecventă, ecosistemele necesare pentru AI la periferie (AI at the edge) încă nu au fost dezvoltate. În cazul instrumentelor software pentru modele, precum TensorFlow Lite, TensorFlow Micro, PyTorch, ONNX și Caffe, acestea devin mai standardizate. Totuși, cu generația actuală de compilatoare și framework-uri de execuție, se obține o experiență foarte specifică furnizorului și proprietară, în același timp. Prin urmare, este necesară o abordare open-source pentru accelerarea implementărilor.

Depășirea provocărilor în domeniul procesării Edge IoT

Synaptics a răspuns la aceste provocări prin lansarea platformei de calcul embedded Astra “AI-Native”. Platforma Astra unifică ecosistemul IoT fragmentat, oferind dezvoltatorului o experiență standardizată și coerentă pe diferite segmente de piață, inclusiv dispozitive de larg consum, pentru întreprinderi și pentru aplicații industriale. Aceasta se bazează pe sisteme pe cip (SoC) scalabile, cu software open-source și instrumente de dezvoltare, susținute de soluțiile de conectivitate Synaptics Veros și de un ecosistem dinamic de parteneri.

Kiturile de dezvoltare Astra Machina sprijină prototiparea rapidă și oferă o experiență de dezvoltare solidă pentru inginerii implicați în aplicații AI Edge. (Sursă imagine: Synaptics)

Siliciul are integrate unități de procesare neurală (NPU), unități centrale de procesare (CPU), unități de procesare grafică (GPU) și procesoare digitale de semnal (DSP) și poate fi scalat de la zeci de GOPS (giga operații pe secundă) la 8 TOPS (tera operații pe secundă) pentru aplicații mai complexe din gama Linux și Android, bazate pe microprocesoare. Această scalabilitate permite platformei să acopere un spectru larg de aplicații IoT, de la dispozitive simple cu un singur senzor la sisteme multimodale care oferă context LM (learning models – sau machine learning models) cu consum redus de putere pentru a oferi produse finale mai imersive și intuitive.

Compania și-a valorificat cunoștințele pentru a se focaliza pe aplicațiile AI IoT care utilizează viziunea ca modalitate principală de detectare. Provocarea constă în reducerea dimensiunii acestor modele pentru a se potrivi constrângerilor sistemelor IoT fără a compromite experiența utilizatorului. Synaptics explorează, de asemenea, alte modalități, cum ar fi vocea și sunetul, pentru a perfecționa aceste experiențe, mai personalizate, pentru utilizatori.

Pentru a sprijini dezvoltarea soluțiilor edge AI IoT, Synaptics a înființat AI Developer Zone, un mediu bogat în resurse creat pentru a permite dezvoltatorilor să creeze aplicații AI. Zona oferă SDK-uri open-source și instrumente bazate pe cloud, care simplifică procesul de dezvoltare, făcându-l mai accesibil pentru o gamă mai largă de dezvoltatori. Această inițiativă face parte din angajamentul de a promova o comunitate de dezvoltatori activă și dinamică, în măsură să valorifice microcontrolerele și microprocesoarele sale AI-native, precum și motoarele de inferență AI adaptive NPU.

Platforma Astra abordează, de asemenea, problema critică a securității în proiectele AI IoT. Bazându-se pe experiența sa cu producătorii de set-top box-uri (STB), care au cerințe stricte de securitate cibernetică, Synaptics a creat un flux de lucru securizat pentru inferența AI. Hardware-ul platformei și compilatorul SyNAP dispun de tehnici de izolare care completează straturile de securitate software, asigurând apărări solide împotriva amenințărilor cibernetice.

Platforma Synaptics Astra este poziționată strategic pentru a profita de creșterea preconizată în piața semiconductorilor pentru calcul, oferind o abordare AI-nativă, construită special pentru IoT. SoC-urile platformei dispun de motoare AI care rulează pe microcontrolere AI cu consum redus de putere până la microprocesoare MPU de înaltă performanță, oferind o arhitectură unificată ce poate fi extinsă la diferite niveluri de performanță. Seria de kituri de dezvoltare Astra Machina Foundation oferită de Synaptics sprijină prototiparea rapidă și oferă o experiență de dezvoltare unitară.

Modelarea viitorului Edge AI IoT

Pe măsură ce piața continuă să evolueze, platforma de calcul embedded Astra “AI-Native” poziționează Synaptics ca lider în tehnologie și gândire în domeniul AI pentru IoT. Platforma a fost proiectată pentru a asigura o experiență de utilizare solidă, oferind suport pentru prototipare rapidă, capacitate de procesare adaptată nevoilor și conectivitate pentru Linux și Android cu ajutorul pachetelor de suport pentru plăci (BSP) open-source.

“AI Developer Zone” a companiei Synaptics (https://developer.synaptics.com/) și inițiativele open-source permit dezvoltatorilor să învețe și să dezvolte aplicații AI Edge. Kitul Astra Machina poate fi achiziționat online și este, de asemenea, susținut pe GitHub.

Edge AI va juca un rol esențial în IoT, oferind o modalitate de a gestiona avalanșa de date, oferind în același timp experiențe îmbunătățite utilizatorilor. Prin platforma Astra, prin accentul pus pe instrumentele open-source și prin sprijinul acordat dezvoltatorilor, Synaptics contribuie la tranziția către experiențe de utilizare mai inteligente și mai intuitive la scară largă.

Autor: Nebu Philips,

Senior Director, Strategy and Business Development

Synaptics Incorporated

Despre autor:

Augustine Nebu Philips este Senior Director of Strategy and Business Development la Synaptics Incorporated, unde are rolul de a supraveghea inițiativele strategice și de a stimula creșterea afacerilor în domeniul IoT și al soluțiilor pentru procesoare edge. Înainte de a se alătura Synaptics, Nebu a fost Senior Director of Product Marketing la Xsight Labs. A petrecut aproape șase ani la Arm, unde a condus operațiunile de marketing axate pe rețele pentru întreprinderi și centre de date. De asemenea, a ocupat poziții de conducere la AMD și Broadcom. Are o diplomă de masterat în informatică obținută de la Universitatea din Nebraska-Lincoln și un MBA în marketing de la Școala de afaceri Leavey a Universității Santa Clara.